Obsolescencia programada, una reflexión

Cuando se habla de «obsolescencia programada» siempre digo que existe desde hace muchos años y por muchas razones, pero no necesariamente es mala. El término es aplicable sólo cuando el fabricante, con malicia, pone una fecha de caducidad a un producto sin motivo justificado, lo que llamamos una «bomba de tiempo». Ahora bien, si existe un motivo técnico justificado pues yo no lo consideraría «obsolescencia programada», por tanto, la inmensa mayoría de las cosas que se les dice tener «obsolescencia programada» no es así.

Uno de los ejemplos que suelo poner, que todos conocemos, de «obsolescencia programada» mucho antes de que se acuñara el término es el de la correa de distribución en los coches. Se suele decir que se deben cambiar a los 100.000 km… Es una «obsolescencia programada» que está basada en unos criterios técnicos y económicos. Los estudios que harán los fabricantes seguramente determinan que una vez superado ese ciclo de trabajo la fiabilidad del componente deja de ser aceptable y entra dentro del riesgo inasumible cuyo fallo puede ocasionar un daño mucho mayor.

¿Podrían hacer cadenas de distribución con ciclos de 200.000 o 300.000 km? Posiblemente podrían pero quizás necesitarían construir los motores con materiales cuyo precio los dispararía, además de que igual en una cierta cantidad de vehículos esos ciclos no llegarían a consumirse, elevando el coste del vehículo o de la fabricación por encima de lo deseable. La diferencia, en los coches antiguos frente a los nuevos es que eras tú el responsable de aumentar el ciclo y pasarte de km. Tengo entendido que en los nuevos coches la electrónica te avisa de estos ciclos y detiene el coche en caso de que superes los límites marcados… ¿Es eso obsolescencia programada?

Con los cartuchos de inyección pasaba un poco lo mismo… si el cartucho se agota, el sistema de inyección podría llegar a bombear aire, vaciar los tubos de tinta y que los inyectores se vaciaran y con ello su daño irreparable. Podrían poner un detector que bloqueara el cartucho cuando no quedara tinta pero quizás ese mecanismo «hidráulico» era más complejo que estudiar estadísticamente cuántas páginas de media se podían imprimir con un cartucho y una vez alcanzadas el chip del cartucho bloquea la impresora para impedir más daños.

Con la fabricación de los dispositivos electrónicos es algo similar, la calidad y durabilidad de cada uno de los pequeños elementos que conforman un circuito electrónico tiene sus estadísticas de tiempo medio entre fallos, tolerancias, temperaturas y tiempos de trabajo, etc… el coste de los mismos va asociado a dicha calidad…

Un componente estándar (es un ejemplo) puede tener un ciclo de trabajo de 50.000 horas, una temperatura de trabajo de 10-50º y un coste de 20 céntimos. Si se precisan 1000 componentes, y cada uno con sus características y costes, el sistema de diseño actual puede encontrar un equilibrio entre una vida media o una estadística de ciclo útil razonable, pongamos de 3, 4 o 5 años y un precio razonable que permita competir en el mercado.

Por otro lado, un componente de «calidad militar» puede tener un ciclo de trabajo de 1 millón de horas, un rango de temperaturas de -10º a 60º C y un coste de 50 céntimos. Si el precio no es el problema pero la durabilidad o la calidad sí, el sistema de diseño incluirá sin dudarlo todos los componentes de esta calidad. Cuando hay que llegar a un equilibrio, pues como veis, hay muchos puntos intermedios que son parametrizables.

¿Y qué pasa con los ordenadores y el software? ¿Por qué tenemos que cambiar de móvil o de ordenador cada 2 o 5 años? Este es otro tema que es difícil de ver pero que también se justifica.

La potencia de los equipos informáticos va creciendo con el tiempo, esto es, que tienen mayores capacidades de proceso por unidad de tiempo, vamos, son capaces de hacer más cosas en menos tiempo. Pero, de la misma manera, conforme pasa el tiempo, usamos los equipos para hacer más cosas y estas cosas que hace cada vez son más complejas. Básicamente el avance del software, nos permite que pretendamos usar hoy para resolver un polinomio complejo con una calculadora que compramos hace 5 años que hace simples sumas.

Sin darnos cuenta, cada nueva versión de programa que usamos, incluye mejoras, crece su tamaño, trabaja más en tiempo real, crecen sus prestaciones, etc… y todo ello en cada nueva actualización. Así, un Facebook que hace unos años se mostraba como una página estática en un navegador que refrescábamos a mano, ahora es un sistema interactivo con vida propia que en tiempo real se comunica con los servidores de Internet, te actualiza imágenes, vídeos, notificaciones, te notifica las acciones que otros están haciendo «Fulanito está escribiendo…» etc… y sin despeinarse… ¿Es obsolescencia programada que todas esas nuevas prestaciones las tengas disponibles en un terminal de hace 3 años pero no en uno de 4? Pues quizás no, quizás (casi seguro) el fabricante del programa/app no puede mantener varias versiones distintas, unas con todas las prestaciones y otras capadas para que funcionen en equipos antiguos.

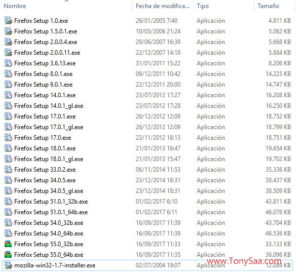

Para esto siempre muestro la evolución de, por ejemplo, los navegadores de Internet como el Firefox… cualquiera que vea el tamaño que ha ido cogiendo el navegador se puede imaginar la cantidad de cosas que hace ahora un navegador de Internet que no hacía hace 10 años… y para hacer todo eso se necesita potencia de cálculo… ¿Obsolescencia programada? ¡No! ¡Evolución tecnológica!

Para los que nunca os habéis fijado en cómo han crecido los navegadores de Internet os muestro una captura de la carpeta de mi servidor donde guardo algunas versiones descargadas a lo largo de los años… con el tamaño que ocupa el instalador para Windows os podéis hacer una idea de cómo ha crecido su complejidad… más cosas que hacer generalmente precisan más potencia de proceso.

Respuesta